aus FAZ.NET, 19. 11. 2020

Schieberegler für die Körper

Noch ist gute digitale Bildmanipulationen harte Arbeit, neue Technik macht sie immer einfacher. Und nun gibt es auch Software, mit der sich Menschen in Filmen mühelos verändern lassen.

Von Tim Schröder

„Nicht einmal ich sehe aus wie Cindy Crawford, wenn ich morgens wach werde“, gestand das amerikanisch Supermodel vor Jahren in einem Interview. Dass Cindy Crawford auf Fotos trotzdem immer wie Cindy Crawford aussieht, liegt natürlich am Make-up, zum Teil aber auch daran, dass man die Bilder von Schönheiten wie ihr in der Regel am Computer weiter aufhübscht. Ein Pickelchen hier, ein Äderchen dort – kurz mit der Maus drüber, und weg ist der Makel. Auch ganze Köpferformen zu korrigieren ist heute kein Problem mehr; junge Menschen lassen sich in alte verwandeln, dicke in dünne. Software zur digitalen Bildbearbeitung ist mittlerweile so leistungsfähig, dass oft höchstens noch Fachleute zwischen falsch und echt unterscheiden können.

Bis vor kurzem galt das nur für Fotos. Jetzt wurde eine Software entwickelt, mit der sich spielend leicht Menschen in Videofilmen modifizieren lassen. Es genügt, kleine Schieberegler auf dem Bildschirm hin und her zu bewegen, schon schrumpft oder wächst der Darsteller. Je nach Bedarf nimmt die Muskelmasse zu oder der Bauchansatz. Vorerst existiert in den Labors des Max-Planck-Instituts für Informatik in Saarbrücken nur ein Prototyp der neuen Bildbearbeitungssoftware. Im Internet wurde das Demo-Video aber schon hunderttausendfach angeklickt (www.mpi-inf.mpg.de/resources/MovieReshape/MovieReshape.avi). Zu sehen ist, wie ein männlicher Baywatch-Star über den Strand joggt, mal mit flacher Brustmuskulatur, mal mit gewölbter.

Dahinter steckt harte Arbeit

„Jetzt sind nicht einmal mehr Videos vor Fälschern sicher“, schimpfen Kritiker. Thorsten Thormählen, Gruppenleiter der Saarbrücker Spezialisten, kennt die Bedenken. Für ihn ist die neue Software vor allem ein Hilfsmittel, um professionelle Filmaufnahmen aufzupeppen. „Bislang futtert sich mancher Hollywoodstar für eine Filmrolle Pfunde an“, sagt Thormählen, „mit unserer Software ließe sich das völlig stressfrei am Computer erledigen.“ Im Fitness-Studio könnte man Videos zur Motivation anbieten: „So werde ich aussehen, wenn ich dreimal die Woche trainiere.“

Die Leichtigkeit, mit welcher der Baywatch-Adonis durch den Sand läuft, täuscht darüber hinweg, dass die Entwicklung des „MovieReshape“ für die Saarbrücker Informatiker harte Arbeit war. Zunächst haben sie die Körper von 100 Probanden eingescannt und aus den Daten am Computer einen Durchschnittskörper, ein „morphable body model“ (verformbares Körpermodell) erzeugt. Zugleich lernte der Computer, zwischen dick und dünn, lang und kurz, flacher oder spitzer Nase zu unterscheiden.

Körperscans helfen zu richtigen Proportionen

Füttern die Forscher den Computer jetzt mit einer Videosequenz, passt ihr Programm das digitale Körpermodell automatisch an die Gestalt im Film an – und zwar für jedes Einzelbild. Bei einem flimmerfreien Video sind das immerhin 25 Bilder pro Sekunde. Eine solche automatische Bildanalyse dauert derzeit noch Stunden. Dann aber geht es schnell. Hat der Computer alle Bilder und die Positionen des Darstellers analysiert, genügt ein Zug am Schieberegler, und der Körper wächst oder schrumpft nach Gutdünken – und zwar in der gesamten Sequenz gleichmäßig.

Dabei muss der Körper anatomisch korrekt verformt werden. Es genügt ja nicht, einfach nur Bauch und Beine in die Länge zu ziehen. Auch die Dicke der Gliedmaßen oder des Rumpfes muss sich ändern, sonst wirkt die Figur schnell wie eine Karikatur. Das Wissen über die richtigen Proportionen zieht die Software aus den gespeicherten Körperscans.

Abschied von der „Pixelschubserei“

Thormählen und seine Kollegen haben die Bearbeitung bewegter Bilder damit also quasi automatisiert. Im Dezember stellen sie ihre Software in Seoul auf der Siggraph Asia vor, einer Computer-Grafik-Messe, auf der sich regelmäßig Firmen wie Pixar oder Disney tummeln. Daniel Cohen-Or wiederum, Informatiker von der Universität Tel Aviv, hat mit Kollegen eine ganz ähnliche Bilder-Morph-Software bereits vor einem halben Jahr auf der letzten Siggraph in New Orleans präsentiert.

Diese bearbeitet Bilder ebenfalls mit Hilfe eines digitalen Körpermodells – allerdings nur Fotos, keine Videos. Aber auch Cohen-Or verabschiedet sich von der mühsamen Handarbeit. „Pixelschubserei“ nennen Experten herablassend das, was man heute mit handelsüblicher Bildbearbeitungssoftware macht. Auf dem Bildschirm gibt es Radiergummi-Symbole und Pinselchen, mit denen der Geduldige Stück für Stück Schatten aufhellt, Fältchen glättet und Taillen schrumpft.

„Es gehört eine Menge Geschick und viel Zeit dazu, dabei die Körperproportionen zu bewahren“, sagt Cohen-Or. Einen dicken Kopf auf dünnem Hals oder Elefantenbeine zur Wespentaille gibt es bei den Israelis nicht. Wie Thormälens Software greift auch das Programm aus Tel Aviv auf statistisches Körperwissen zurück, wenn es Menschen streckt oder staucht. Der digitale Manipulator kämpft sich damit nicht mehr von Bildpunkt zu Bildpunkt: Er arbeitet vollautomatisch.

Der „Uncanny-Valley“-Effekt

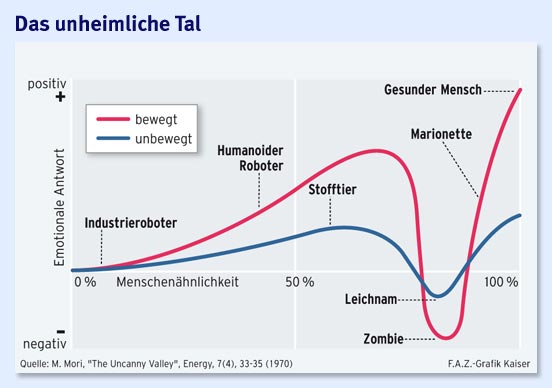

Der Heilige Gral der Computergrafik aber bleibt das Gesicht. Menschen sind ziemlich gut darin, feinste Abweichungen von der Norm zu erkennen. Dünne Hälse im gefälschten Bild sind bis zu einem gewissen Grad tolerierbar. Eine falsche Reflexion im Auge oder ein merkwürdiger Glanz in der Iris wirken dagegen unnatürlich. Der Betrachter empfindet das Kunstgesicht unweigerlich als irritierend. „Uncanny-Valley“-Effekt nennen Fachleute dieses Phänomen (siehe Grafik „Das unheimliche Tal“). Gemeint ist damit, dass uns künstliche Gesichter mit steigender „Menschenähnlichkeit“ nicht einfach immer vertrauter erscheinen.

Im Gegenteil: Absolut künstliche Comicfiguren wie zum Beispiel Bugs Bunny empfinden wir als sympathisch. Auch ein humanoider Roboter mit Blecharmen und kugeligen Kameraaugen spricht uns an. Doch eine fast lebensechte Roboterpuppe mit Gummihaut und Glaspupille stürzt in unserer Gunst ab. Zu nah und zugleich zu befremdlich ist uns ein solcher Android. Damit ein Kunstgesicht nicht „uncanny“ (englisch für unheimlich) erscheint, muss es schon mit echten Falten und dem rechten Blick ausgestattet sein.

Der Begriff „uncanny“ ist zu „schwammig“

Die Vorstellung von einem solchen „Uncanny-Valley“ geht auf den japanischen Roboter-Spezialisten Masahiro Mori zurück, der sie 1970 erstmals formulierte. Mori dachte dabei nicht nur an Gesichter, sondern auch an die frühen Roboter, die mechanisch-steif durch die Gegend stelzten. Lange interessierte sich kaum jemand für die Idee. Doch mit dem boomenden Computerspiel-Markt und den ersten vollständig computeranimierten Filmen Mitte der 1990er Jahre wurde das „Uncanny-Valley“ bald zu einem Modebegriff. Floppt ein neuer Animationsfilm, hat man heute schnell eine Antwort parat: Die Figuren seien uncanny, heißt es.

Martin Breidt vom Max-Planck-Institut für Biologische Kybernetik in Tübingen wäre da vorsichtiger. Noch ist die Existenz eines „Uncanny-Valley“-Effekts nur eine Hypothese ohne saubere empirische Basis. Der Informatiker will herausfinden, was ein Kunstgesicht letztlich uncanny macht. „In früheren Studien wurden Probanden gebeten, auf einer Skala einzuschätzen, ob sie ein Gesicht als uncanny empfinden“, sagt Breidt, „das ist allerdings recht schwammig.“ Zusammen mit Kollegen vom Trinity-College in Dublin veröffentlicht Breidt in Kürze eine erste Studie, in der er sich dem Thema quasi durch die Hintertür nähert.

Verfremdete Köpfe wirken vertrauensvoller

Er hat untersucht, inwieweit Versuchspersonen einem Computergesicht vertrauen. Breidt hat dazu eine Mitarbeiterin per Videokamera aufgenommen, während diese Fragen zu ihrer Person falsch oder richtig beantwortet. Anschließend verwandelte er das Gesicht am Computer in drei künstliche Digitalköpfe: einen, der klar als Kunstgesicht zu erkennen ist, einen zweiten, der nicht ganz so verfremdet wirkt, und einen dritten, der einem echten Gesicht schon recht nahekommt. Dann spielte er die digitalisierten Videosequenzen mit Originalton und identischer Bewegung ab.

Nach jeder Sequenz mussten die Probanden entscheiden, ob sie die Aussage für wahr oder gelogen hielten. Tatsächlich trauten sie dem menschenähnlichsten Gesicht am wenigsten. Die beiden stärker verfremdeten Köpfe schnitten deutlich besser ab. „Gut möglich, dass das menschenähnliche Gesicht uncanny und damit weniger vertrauensvoll erscheint“, sagt Breidt. Er kann sich vorstellen, dass Ergebnisse dieser Art für den Einsatz im Internet von Interesse sein könnten – für digitale Autoverkäufer zum Beispiel. Will man das Vertrauen des Kunden gewinnen, ist es möglicherweise besser, eine stilisierte Figur zum Käufer sprechen zu lassen als einen aufwendig gestalteten Kunstkopf, der am Ende uncanny wirkt.

„Digital Emily“ mit lebendiger Frische

Breidt würde seine Experimente gern mit einem der seiner Ansicht nach besten digitalen Menschengesichter überprüfen, die derzeit in der virtuellen Welt existieren, der „Digital Emily“. Das ist der digitale Gesichtsabdruck der amerikanischen Schauspielerin Emily O’Brien, ein Kunstprodukt der Firma Image Metrics und von Forschern der University of Southern California. Emily wirkt im Video so echt, dass man nicht mehr erkennen kann, ob die wahre oder die digitale Filmsequenz abgespielt wird. Breidt nimmt an, dass es den Amerikanern mit „Digital Emily“ tatsächlich gelungen ist, das Tal des Unheimlichen zu überschreiten.

Das wichtigste Werkzeug der Spezialisten von Image Metrics ist eine Art Kugelkäfig, die Light-Stage, in der eine Person abgelichtet wird. Die Kugel ist mit fast 200 computergesteuerten LED-Lampen bestückt. Die Forscher können die Helligkeit und mit Hilfe von Filtern die Ausrichtung des Lichts exakt definieren und die Reflexionen im Gesicht genau vermessen. Da bekannt ist, aus welcher Richtung das Licht einfällt, lässt sich aus der Reflexion auf die Hautstruktur schließen. Damit werden selbst kleinste Falten und sogar die Poren der Haut sichtbar. Das ist der Clou, erst dadurch bekommt die Haut der digitalen Emily die lebendige Frische, die anderen Kunstfiguren bisher fehlt.

„Benjamin Button“ – tatsächlich perfekt

Die Light-Stage kam auch bei der Produktion von „Benjamin Button“ zum Einsatz, einem Film, in dem Brad Pitt die Titelrolle spielt. Für Martin Breidt ist das Werk derzeit die Messlatte in Sachen digitaler Menschwerdung. „Benjamin Button“ erzählt die Geschichte eines Mannes, der als Greis geboren und mit den Jahren immer jünger wird. Das Filmteam verzichtete auf Schminke – „zu unecht“, meinten die Produzenten. Stattdessen entschieden sie sich, den alten Pitt komplett im Computer zu generieren. „Der Film ist nicht besonders“, meint Martin Breidt, „aber in den ersten 50 Minuten stammt das Gesicht von Brad Pitt komplett aus dem Rechner, unglaublich.“ Breidt schaut voller Respekt nach Amerika. „Die haben keine Technik neu erfunden, aber alles, was verfügbar war, bis zum Ende ausgereizt.“

150 Personen arbeiteten zwei Jahre lang an den digitalen Sequenzen. Brad Pitts Mimik wurde eingescannt. Drei Kunststoffköpfe wurden modelliert – der Kopf eines 60-, 70- und 80-Jährigen. Sie dienten als Referenzen, an denen man das digitale Gesicht altern ließ. In den Szenen laufen, springen und baden „Body Actors“, Behelfsschauspieler, in deren Köpfe später am Computer das animierte Gesicht des gealterten Pitt eingepasst wurde. Ein Mitarbeiter arbeitete allein ein ganzes Jahr an einem digitalen Augenmodell und rückte die Reflexionen an den rechten Fleck, damit nichts mehr „uncanny“ wirkt. Das Ergebnis ist tatsächlich perfekt. Zugleich ist es beunruhigend, weil echt und falsch verschwimmen wie nie zuvor.

Nichts für Allerweltsfälscher

Unlängst stellte der Chef-Grafiker Ed Ulbrich die Benjamin-Button-Spezialtechnik der Öffentlichkeit vor. Die Leute klatschten begeistert, von Unbehagen keine Spur. Auch Martin Breidt ist nicht wirklich besorgt. „Natürlich kann man heute digitale Daten, vor allem Bilder und in jüngerer Zeit auch Videos mit vertretbarem Zeitaufwand manipulieren und fälschen“, sagt er.

„Ein Foto gilt kaum mehr als Beweismittel.“ Und Urlaubsfilmen wird angesichts dessen, was die Saarbrücker Informatiker mit Ihrer Software können, bald auch nicht mehr recht zu trauen sein. Allerdings, ein bewegtes Gesicht in hoher Qualität lebensecht im Video nachzubauen, das sei die Königsklasse, sagt Breidt, und für den Allerweltsfälscher zumindest heute noch unmöglich. „Noch ist das Hollywood.“